Deine Spende wird heute verdoppelt

Jede Spende bis zum 31. Dezember wird verdoppelt. So entfaltet dein Beitrag doppelte Wirkung und schützt weltweit die Rechte von Menschen in Gefahr.

„Fasse mir diesen Report in vier Sätzen zusammen!“, „Schreibe fünf Titelvorschläge für diesen Text!“ oder „Erstelle ein Referat zum Thema Wale!“ – ChatGPT Prompts sind für viele Menschen zum Alltag geworden. Der populäre Chatbot ist das wohl bekannteste Beispiel für die alltägliche Nutzung Künstlicher Intelligenz (KI). Doch KI ist heute in vielen weiteren Bereichen Bestandteil unseres täglichen Lebens geworden, etwa in Navigationssystemen im Auto, im Smart Home oder bei medizinischen Geräten. Die neuen Technologien haben sich in rasantem Tempo etabliert. Neben vielen hilfreichen Einsatzmöglichkeiten bringt Künstliche Intelligenz allerdings massive Risiken mit sich: Überwachung, Diskriminierung und sogar tödliche Gefahren durch automatisierten Einsatz von Waffen sind die dunkle Kehrseite der KI-Medaille. Darum ist es entscheidend, KI-Systeme mit Blick auf unsere Menschenrechte gut zu verstehen und bei ihrem Einsatz einen menschenrechtsbasierten Ansatz zu verfolgen. Worauf es dabei ankommt und vor welchen Risiken wir uns dringend schützen müssen, erfährst du auf dieser Seite.

> Die drei wichtigsten Begriffe: Was sind KI, Generative KI und Algorithmen?

> Chancen: Wie kann Künstliche Intelligenz den Einsatz für Menschenrechte unterstützen?

> KI und Menschenrechte: Forderungen von Amnesty International

> Welche KI-Systeme müssen verboten, um Menschenrechte zu schützen?

Künstliche Intelligenz (KI) bezieht sich auf die Simulation menschlicher Intelligenz in Maschinen bzw. Computerprogrammen. Dadurch können Programme Aufgaben erledigen, die normalerweise menschliche Intelligenz erfordern. Dazu gehören z.B. Problemlösungen, Lernen, Spracherkennung und -übersetzung, visuelle Wahrnehmung und Entscheidungsfindung. KI wird in verschiedensten Bereichen eingesetzt, so z.B. im Gesundheitswesen, im Finanzbereich, für Überwachung, Bildung oder Unterhaltung.

Generative KI (GAI) ist eine Teilmenge von KI, die sich darauf konzentriert, autonom neue Inhalte wie Bilder, Texte, Musik oder auch Computercodes zu erstellen. Anhand umfangreicher Datensätze kann GAI vielfältige Ergebnisse erzeugen. Bekannte Beispiele von Generativer Künstlicher Intelligenz sind ChatGPT, Dall-E oder Midjourney. Während diese Tools für die Erstellung von Inhalten hilfreich sind, besteht gleichzeitig die Gefahr des Missbrauchs durch die Erzeugung von Deep Fakes. Außerdem stellen sich Urheberrechtsfragen hinsichtlich der für das Training der GAI verwendeten Daten.

Ein Algorithmus ist eine Reihe von Anweisungen oder Regeln, denen ein Computerprogramm folgt, um bestimmte Aufgaben zu erfüllen oder ein Problem zu lösen. Diese Anweisungen müssen in der richtigen Reihenfolge erfolgen, vergleichbar mit einem Kochrezept.

Vorurteile (in diesem Zusammenhang auch bekannt unter dem englischen Begriff Bias), die bei der Programmierung bzw. beim Training in Algorithmen und KI-Systeme einfließen, können zu Diskriminierung führen. Oft werden auch Daten zum Training von KI-Systemen verwendet, die schon Diskriminierung bzw. Bias beinhalten, zum Beispiel hinsichtlich Hautfarbe oder Geschlecht. Das führt in Folge dazu, dass bestehende Diskriminierung reproduziert bzw. sogar verstärkt wird.

Eine große Herausforderung bei der Nutzung von Künstlicher Intelligenz ist, dass deren Nutzer*innen meist die Tendenz haben, sich auf automatisierte Prozesse zu verlassen. Oft bewerten Menschen KI- und ADM-Systeme (Algorithmische Entscheidungssysteme) als neutral, zuverlässig und vertrauenswürdig. Deshalb neigen sie dazu, diesen Systemen mehr Bedeutung zuzumessen als anderen Quellen und Grundlagen. Dies kann in Folge zu Fehlern in der Entscheidungsfindung führen und dazu, dass Bias im System unhinterfragt übernommen wird.

In den letzten Jahren gab es vermehrt Fälle von Verwendung von Gesichtserkennungstools, die zu falschen Festnahmen führten. Davon betroffen waren vor allem Personen mit nicht-weißer Hautfarbe, da die Gesichtserkennungssoftware Menschen mit nicht-weißer Hautfarbe unverhältnismäßig häufig falsch identifiziert.

Staaten greifen auch in ihren Sozialversicherungssystemen zunehmend auf den Einsatz digitaler Technologien zurück. Die Staaten stellen solche Systeme oft als neutrale oder technokratische Lösung dar, die die Verwaltung verbessern, Betrug erkennen und die Sicherheit erhöhen sollen. Umfangreiche Recherchen zeigen, dass die Digitalisierung bei der Verwaltung von sozialer Unterstützungsleistungen viele Risiken für das Menschenrecht auf soziale Sicherheit birgt und Ungleichheit verschärfen kann. Beispielsweise ergab eine Untersuchung von Amnesty International in Serbien, dass die Einführung einer halbautomatischen Entscheidungsfindung bei der Prüfung des Anspruchs auf Sozialleistungen einige der am stärksten ausgegrenzten Personengruppen am meisten betraf. Ähnlich ist die Lage auch bei der Bedrohung unseres Rechts auf Gesundheit: In der jüngsten Vergangenheit beginnen immer mehr staatliche und private Stellen, KI-unterstützte oder KI-gesteuerte Systeme zu benutzen, deren Grundlage oftmals fraglich oder fehlerhaft ist und deren Algorithmus lediglich auf einem Durchschnittswert basiert, jedoch nicht auf die einzelnen spezifischen Erfordernisse der betroffenen Personen eingeht. Die daraus hervorgehenden Entscheidungen können enorme Auswirkung auf die gesundheitliche und finanzielle Situation der Betroffenen haben.

Der US-Amerikaner Robert Williams wurde im Jänner 2020 in seinem Garten vor seiner Frau und seinen zwei Töchtern von der Polizei verhaftet. Ihm wurde vorgeworfen, Uhren aus einem Geschäft in Detroit gestohlen zu haben. Die Verhaftung basierte auf einem Abgleich der Aufnahmen der Überwachungskamera mit einer Gesichtserkennungssoftware. Diese neigte zu Fehleranfälligkeit, vor allem bei Menschen mit nicht weißer Hautfarbe. Tatsächlich war Williams zum Zeitpunkt des Überfalls in seinem Auto auf dem Heimweg von der Arbeit.

"In meinem Fall hätte die Polizei von Detroit Übereinstimmungen bei der Gesichtserkennung als Ermittlungshilfe betrachten sollen und nicht als einzigen Beweis, den sie braucht, um jemanden eines Verbrechens anzuklagen", schrieb Williams in einem Brief an den Ausschuss für öffentliche Sicherheit des kalifornischen Parlaments. "Sie hätten zusätzliche Beweise wie die Identifizierung durch einen Augenzeugen, die Standortdaten eines Mobiltelefons oder einen Fingerabdruck sammeln müssen. Sie hatten nichts von alledem – nur ein unscharfes Bild eines großen Schwarzen Mannes mit Baseballmütze, den ein fehlerhafter Algorithmus für mich gehalten hatte."

Die niederländische Steuerbehörde verwendete zur automatisierten Verarbeitung von Sozialleistungsansprüchen eine Anwendung, die durch Algorithmen und KI gesteuert wurde. Diese wies jedoch gravierende Mängel auf: Extrem problematisch war etwa die Praxis der niederländischen Steuerbehörde, Menschen mit doppelter Staatsangehörigkeit pauschal ein hohes Risiko für Betrug zuzusprechen. Tausende Familien wurden fälschlich des Sozialbetrugs bezichtigt – die sogenannte Toeslagenaffaire (deutsch: Kindergeldaffäre) löste einen Skandal aus, die Regierung musste gravierende Fehler mit dramatischen Folgen für die Betroffenen zugeben.

Das sogenannte COMPAS-System, das in einigen US-Bundesstaaten eingesetzt wird, bewertet anhand von über 100 Variablen, ob bei einer inhaftierten Person ein geringes, moderates oder hohes Risiko besteht, dass sie rückfällig wird und erneut eine Straftat begeht. Diese Ergebnisse dienen Richter*innen maßgeblich als Grundlage für ihre Entscheidung. Obwohl das System den Faktor ethnische Herkunft ausklammern soll, hat eine Studie ergeben, dass Schwarze Menschen doppelt so häufig irrtümlich mit einem „hohen Risiko“ eingestuft wurden wie weiße Menschen. Ebenso wurde die Rückfallwahrscheinlichkeit von weißen Menschen unterschätzt.

In der Allgemeinen Erklärung der Menschenrechte (AEMR), der Europäischen Menschenrechtskonvention (EMRK) sowie der Charta der Grundrechte der Europäischen Union (GRC) ist das Recht auf Privatleben bzw. Privatsphäre verankert. Dieses Recht ist in der digitalen Welt durch die aktuellen technologischen Entwicklungen zunehmend in Gefahr. Konzerne verdienen Geld mit Verletzungen unseres Rechts auf Privatsphäre und Gesundheit. Plattformen wie TikTok oder Meta sind auf dem Geschäftsmodell der Überwachung aufgebaut. Sie beobachten Nutzer*innen, um massenhaft Informationen über sie zu sammeln.

Mit Hilfe neuer Technologien wird es immer einfacher, Menschen zu durchleuchten und zu analysieren. Big Tech-Unternehmen sammeln riesige Mengen an Daten von und über uns und setzen Algorithmen und KI ein, um jeden Schritt von uns überwachen zu können, Rückschlüsse auf unser zukünftiges Verhalten oder sonstige Annahmen oder Vorhersagen über uns zu treffen und auch, um die Entscheidungen von Menschen zu beeinflussen.

Amnesty International hat aufgezeigt, dass der Algorithmus von TikTok und anderen diese Informationen nutzt, um die Interessen der Nutzer*innen vorherzusagen, damit diese stundenlang weiterscrollen – was via Werbeanzeigen die Einkünfte der Plattformen steigert. Neben den Problemen hinsichtlich Privatsphäre kann dieses Verhalten auch gesundheitliche Folgen nach sich ziehen.

Amnesty International setzt sich dafür ein, große Technologie- und Social-Media-Unternehmen wie Alphabet (Google), Meta (Facebook), TikTok und X (ehemals Twitter) zur Rechenschaft zu ziehen. Wir zeigen die Schäden auf, die das Geschäftsmodell der Überwachung von Big Tech-Unternehmen verursacht und fordern mehr Transparenz und Rechenschaftspflicht für Big Tech-Unternehmen.

KI-gesteuerte Algorithmen auf großen Online-Plattformen sind oftmals darauf ausgerichtet, die Aktionen der Nutzer*innen zu maximieren. Dadurch wird die Entstehung von Echokammern verstärkt, die sich deutlich auf demokratische Verfahren und persönliche Freiheiten auswirken. Die Manipulation der öffentlichen Meinung wird begünstigt, unsere Möglichkeit, uns mit einem breiten Spektrum an Meinungen auseinanderzusetzen, verringert. Durch die Unterdrückung abweichender Meinungen wird auch das Recht auf Meinungsäußerungsfreiheit und das Recht auf Zugang zu Information eingeschränkt.

Der Skandal rund um die Datenanalyse-Firma Cambridge Analytica hat aufgezeigt, wie leicht persönliche Daten auf unerwartete Weise für Manipulation und Beeinflussung missbraucht werden können. Ein derartiger Missbrauch der Technologie verletzt nicht nur das Prinzip der freien Meinungsäußerung , sondern auch das Recht auf Privatsphäre und hat massive Auswirkungen auf unsere Gesellschaft.

Mit generativer KI generierte Deep Fakes – sei es in Form von Bildern, Videos oder Audioanwendungen – können die öffentliche Meinung manipulieren, Gegner*innen verleumden und den Ruf von Personen zerstören. So hat im Jänner 2024 ein mit Hilfe künstlicher Intelligenz generierter Anruf in New Hampshire anlässlich der Vorwahlen sich als US-Präsident Joe Biden ausgegeben und die Wähler*innen aufgefordert, zu Hause zu bleiben.

Regierungen auf der ganzen Welt verwenden vermehrt biometrische Technologien – von Gesichtserkennung über Körpersprache- bis hin zur Emotionserkennung – und bedrohen damit unsere Menschenrechte. Sie verstärken systematische Diskriminierung, die sich meist gegen ohnehin bereits marginalisierte Gruppen richtet.

Unter dem Deckmantel der „nationalen Sicherheit“ werden Gesichtserkennungssysteme von Regierungen eingesetzt, um Einzelpersonen übermäßig zu überwachen. Die Strafverfolgungsbehörden setzen diese Systeme im öffentlichen Raum ein, um Personen zu identifizieren, die möglicherweise eine Straftat begangen haben oder ihrer Ansicht nach potenziell begehen.

Überwachung kann einen sogenannten „Chilling Effect“ haben, das heißt Menschen vermeiden, ihre Recht auszuüben, weil sie annehmen, dass sie überwacht werden. Dadurch kann es auch Verletzungen des Rechts auf Versammlungsfreiheit bzw. Meinungsäußerungsfreiheit kommen.

Amnesty International setzt sich seit vielen Jahren für ein vollständiges Verbot von biometrischer Überwachung im öffentlichen Raum durch staatliche und private Akteur*innen ein.

Unter dem Vorwand, für mehr Sicherheit zu sorgen, gab es in der Vergangenheit immer wieder nicht umgesetzte Ideen und Forschungsprogramme zum Einsatz von Künstlicher Intelligenz, die einen orwellschen Umfang gehabt und quasi eine durchgehende Überwachung bedeutet hätten. Zum Beispiel das sogenannte „INDECT“-Programm: Im Rahmen dieses EU-Forschungsprogramms war die Zusammenführung bereits gespeicherter Daten und Videoaufzeichnungen mit personenbezogenen Daten aus sozialen Netzwerken geplant. Mittels einer Suchmaschine sollten öffentlich zugängliche Websites oder Foren fortlaufend durchsucht werden und mit Gesichtserkennungstechnologien und Aufnahmen aus Überwachungskameras, sowie Daten aus sozialen Medien zusammengeführt werden, um kriminelle Aktivitäten vorauszusagen.

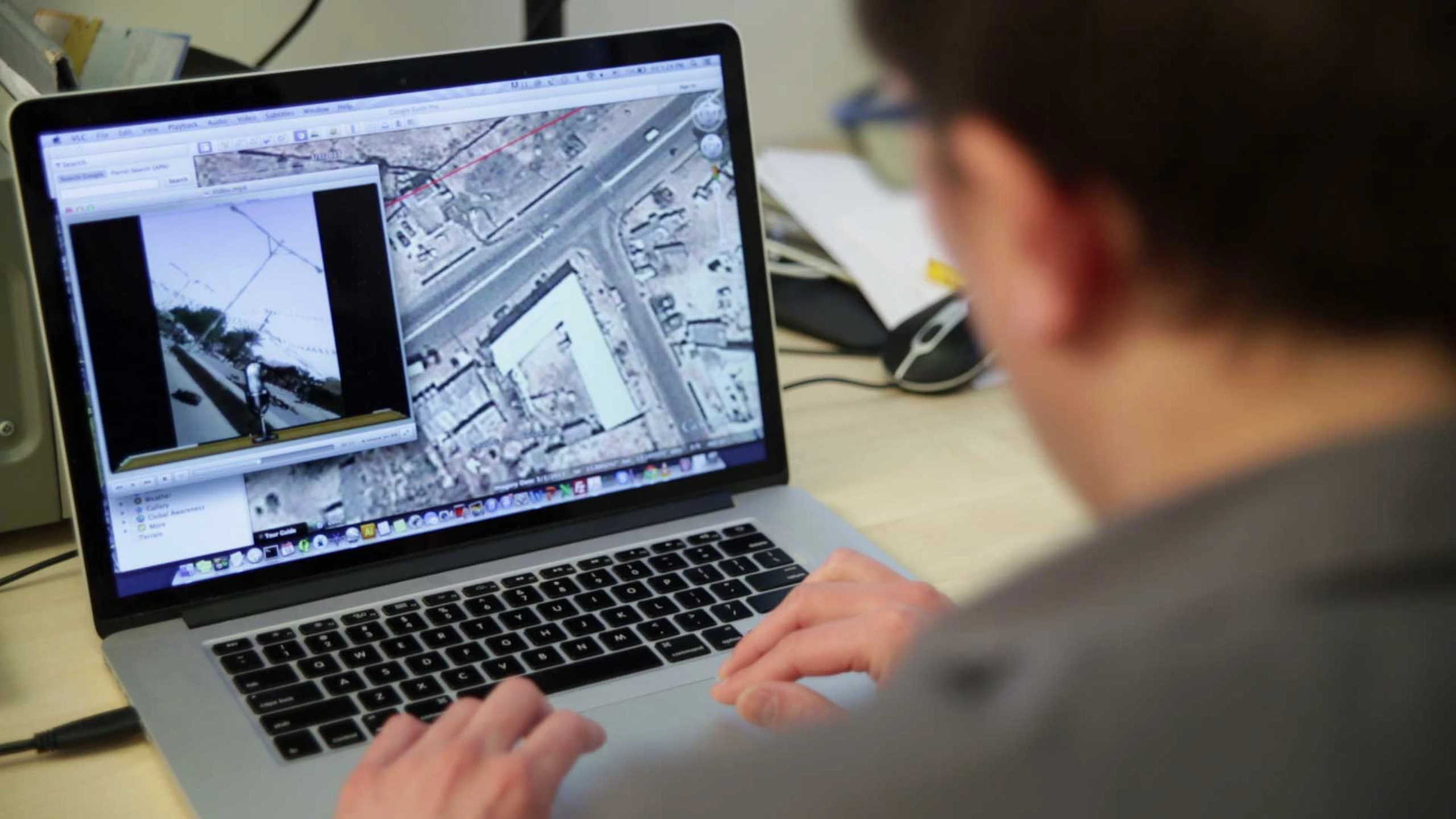

Trotz all der Probleme und Bedenken, die Künstliche Intelligenz im Zusammenhang mit den Menschenrechten mit sich bringt, dürfen neue Technologien nicht generell verteufelt werden. Denn diese Instrumente eröffnen auch neue Chancen. So kann beispielsweise ein KI-Tool, das Daten von Satelliten benutzt, dafür eingesetzt werden, Menschenrechtsverletzungen aufzuzeigen, z.B. die Vernichtung von Dörfern im Kriegsfall oder die Ausweitung von Gefangenenlagern in Nordkorea.

Ein Beispiel für den sinnvollen Einsatz neuer Technologien ist das Digital Verification Corps (DVC) von Amnesty International: In den sozialen Medien kursieren riesige Mengen an Videos und Fotos. Einige davon können Beweise für Menschenrechtsverletzungen darstellen. Gemeinsam mit Studierenden von Universitäten rund um die Welt arbeitet das DVC daran, diese Inhalte auf ihren Wahrheitsgehalt und ihre Relevanz zu überprüfen. In eigenen Trainings lernen die Teilnehmenden digitale Tools zu nutzen, um Material zu recherchieren und zu verifizieren.

Auch das Citizen Evidence Lab von Amnesty International setzt auf digitale Mittel zur Aufdeckung von Menschenrechtsverletzungen. Dabei werden Open-Source-Informationen und neue Methoden genutzt, um Beweismaterial zu verifizieren und zu sichern. Das Citizen Evidence Lab arbeitet außerdem an der Ausbildung von Menschenrechtsresearcher*innen und vermittelt die notwendigen Werkzeuge und Fähigkeiten.

Alle Menschenrechte sind von den Entwicklungen der Künstlichen Intelligenz betroffen. Daher ist es in der Entwicklung von KI, GAI bzw. KI-Tools von grundlegender Bedeutung, einen auf Menschenrechten basierenden Ansatz zu verfolgen. Das heißt: Design, Implementierung, Bereitstellung und Nutzung von KI-Technologien müssen im Einklang mit den grundlegen Prinzipien der Menschenrechte stehen und unsere Freiheiten und Rechte schützen. So können wir das Potential dieser Technologien ausschöpfen und gleichzeitig die damit verbundenen Risiken auf ein Minimum reduzieren.

Die Menschenrechte müssen von der Entwicklung bis zum Einsatz von KI im Mittelpunkt stehen! Amnesty International fordert die Berücksichtigung und Umsetzung folgender Punkte:

Amnesty International fordert ein Verbot von KI-Systemen, die ein unannehmbares Risiko für die Menschenrechte von Menschen und Gemeinschaften darstellen. Einige KI-Anwendungen sind mit den Menschenrechten grundsätzlich nicht vereinbar oder stellen immer ein unvertretbares Risiko dar. Amnesty International setzt sich dafür ein, sie zu verbieten. Dazu gehören:

Künstliche Intelligenz (KI): Allgemein gesprochen ist KI jedes System, das es Computern ermöglicht, menschliches Verhalten zu imitieren. KI bezieht sich auf die Entwicklung von Computersystemen, die Aufgaben ausführen können, die typischerweise menschliche Intelligenz erfordern. Dazu gehören z.B. Problemlösungen, Lernen, Spracherkennung und -übersetzung, visuelle Wahrnehmung und Entscheidungsfindung. KI wird in verschiedensten Bereichen eingesetzt, so z.B. im Gesundheitswesen, im Finanzbereich, für Überwachung, Bildung oder Unterhaltung.

Es gibt jedoch keine Einigkeit über die Definition von KI, da sich der Begriff nicht auf eine einzelne Technologie bezieht, sondern vielmehr eine Vielzahl von technologischen Anwendungen und Methoden umfasst. Die meisten offiziellen Definitionen beziehen sich auf eine Reihe von datengesteuerten Prozessen, die es Computern ermöglichen, sehr spezifische oder allgemeinere Aufgaben wie Entscheidungsfindung oder Problemlösung anstelle von Menschen oder zu deren Unterstützung auszuführen.

Amnesty International wählt diesbezüglich bewusst eine weit gefasste Definition von KI, um die menschenrechtlichen Auswirkungen der verschiedenen Komponenten, Praktiken und Prozesse, die KI-Technologien zugrunde liegen, adäquat und ganzheitlich zu untersuchen.

Generative Künstliche Intelligenz (GAI): Generative KI ist ein Teilbereich von KI, der darauf spezialisiert ist, neue Inhalte wie Bilder, Texte, Musik, aber auch Programmcodes zu erstellen. GAI umfasst Algorithmen, die auf Grundlage von Datenmustern Ergebnisse generieren können. Während dies einerseits die Erstellung von Inhalten erleichtern kann, gibt es gleichzeitig Bedenken, dass diese Technik zur Erzeugung von Deep Fakes genutzt wird.

Algorithmen: Ein Algorithmus ist eine Reihe von Anweisungen oder Regeln, denen ein Computerprogramm folgt, um bestimmte Aufgaben zu erfüllen oder ein Problem zu lösen. Diese Anweisungen müssen in der richtigen Reihenfolge erfolgen, wie z.B. bei einem Kochrezept.

Neuronale Netzwerke: Neuronale Netzwerke sind ein grundlegendes Konzept in der KI. Sie sind rechnerische Modelle, die von der Struktur und Funktion des menschlichen Gehirns inspiriert sind. Neuronale Netzwerke werden in maschinellem Lernen eingesetzt, um Muster zu erkennen, Vorhersagen zu treffen und Aufgaben wie Bild- und Spracherkennung auszuführen.

Deep Fake: Deep Fakes sind manipulierte Medien, die mithilfe von Deep-Learning-Algorithmen erstellt werden. Sie können realistisch aussehende, aber gefälschte Videos, Bilder oder Audioclips erzeugen. Deep Fakes werfen Fragen zur Desinformation, zum Datenschutz und zum potenziellen Missbrauch von KI-Technologie auf.

Halluzination durch KI: Eine Halluzination durch KI tritt auf, wenn KI-Systeme Ergebnisse generieren, die nicht genau sind oder nicht auf echten Daten basieren. Das kann zu imaginären oder inkorrekten Ergebnissen führen und zu Problemen bei der Zuverlässigkeit und Verantwortlichkeit von KI-Anwendungen.

Prompt: Im Kontext von KI-Sprachmodellen bezieht sich der Begriff „Prompt“ auf eine spezifische Eingabe oder Anweisung, die dem (KI-)Modell gegeben wird, um eine Antwort zu generieren oder eine Aufgabe auszuführen. Die Qualität und Art des Prompts spielen eine wichtige Rolle bei der Beeinflussung der Ausgabe, die vom KI-Modell generiert wird.

LLM (Large-Language-Models – Große Sprachmodelle): Im Kontext der künstlichen Intelligenz bezieht sich ein großes Sprachmodell auf einen Typ von maschinellem Lernmodell, das auf umfangreichen Mengen an Textdaten trainiert wird, um menschenähnliche Sprache zu verstehen und zu generieren. Beispiele für große Sprachmodelle sind Chat-GPT, Bert, Turing, LaMBDA.

Biometrische Daten: Daten zu den physischen/biologischen Merkmalen von Menschen, z. B. Fingerabdrücke, Irisabdrücke, Gesichtsbilder und andere sehr persönliche Merkmale. Diese Daten werden häufig zum Zweck der Identifizierung einer Person oder der Authentifizierung ihrer Identität erfasst und gespeichert.

Gesichtserkennung: Eine Technik der Bildverarbeitung – das heißt, eine Methode zur visuellen Identifizierung von Objekten, Personen und Gelände in Computersystemen – wird zur Identifizierung der Gesichter von Menschen verwendet. Dies erfolgt unter Verwendung eines Referenzgesichtsbilds (z.B. eines Bildes, das aus Aufnahmen von Überwachungskameras gewonnen wurde) zusammen mit einem zuvor trainierten Algorithmus. Dieser kann Bilder, die ihm über andere Datenbanken (z.B. Führerscheinregister, Social-Media-Profile usw.) zur Verfügung gestellt werden, zuordnen, identifizieren und vergleichen. Die Gesichtserkennungstechnologie (Facial Recognition Technology, FRT) zur Identifizierung (auch bekannt als 1:1-Gesichtserkennung) ist eine Technologie der Massenüberwachung by Design und stellt als solche eine Verletzung des Recht auf Schutz der Privatsphäre dar.

Die Gesichtserkennung zur Authentifizierung hingegen verwendet einen anderen Prozess, bei dem zwei Bilder direkt verglichen werden und in der Regel die betreffende Person miteinbezieht, beispielsweise wenn ein Bild einer Person direkt mit ihrem Reisepass verglichen wird oder wenn man sein Gesicht zum Entsperren eines Telefons benutzt.

Scraping: Beim Scraping werden Inhalte aus Webseiten ausgelesen, um Informationen zu gewinnen und zu speichern. Man unterscheidet zwischen manuellem und automatischen Scraping. Für automatisches Scraping verwendet man eine Software oder einen Algorithmus, die/der Webseiten durchsucht, um Informationen herauszufiltern, zu speichern und zu indexieren.