Deine Spende wird heute verdoppelt

Jede Spende bis zum 31. Dezember wird verdoppelt. So entfaltet dein Beitrag doppelte Wirkung und schützt weltweit die Rechte von Menschen in Gefahr.

Veröffentlicht am 4.5.2021

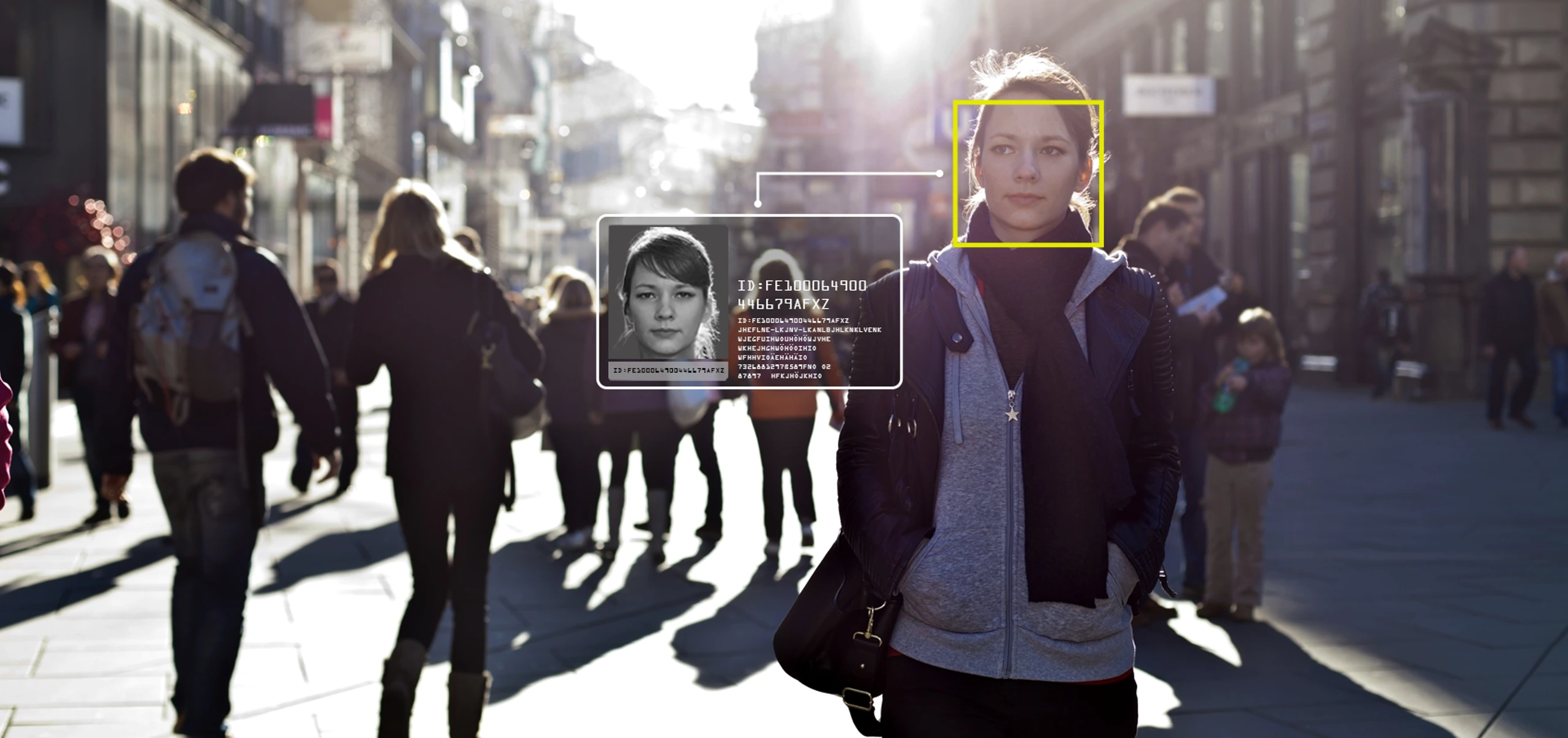

Eine steigende Anzahl von Ländern verwendet Gesichtserkennungstechnologie zur Überwachung des öffentlichen Raumes, auch Österreich. Dabei ist der Einsatz der Technologie ein schwerwiegender Eingriff in unsere Privatsphäre und Menschenrechte, wie ein Amnesty-Bericht zur Gesichtserkennung in Österreich zeigt. Doch wie funktioniert Gesichtserkennung, warum ist die Technologie so problematisch und wie wird Gesichtserkennung in Österreich eingesetzt?

> Auswirkungen auf Versammlungs- und Vereinigungsfreiheit sowie Meinungsäußerungsfreiheit

> Gefahren der Verbreitung und des Ausbaus von Gesichtserkennungstechnologien

Unter Gesichtserkennungstechnologie wird eine Art biometrisches Verfahren verstanden, welches dazu dient, Personen zu identifizieren oder zu authentifizieren. So zielt eine Authentifizierung darauf ab, nachzuweisen, ob es sich bei einer Person um dieselbe Person in einer bestimmten Datenbank handelt und wird häufig zur Überprüfung von Zugangsberechtigungen für beispielsweise ein Smartphone oder für automatisierte Grenzkontrollen auf Flughäfen verwendet. Bei der Authentifizierung geht es also darum, festzustellen, ob eine Person auch die ist, die sie vorgibt zu sein.

Beim Einsatz von Gesichtserkennungstechnologie zur Identifizierung – die häufig auch von Strafverfolgungsbehörden, aber auch z.B. von Facebook zur Anwendung kommt – geht es hingegen darum, eine Person anhand ihres Gesichts unter einer Reihe von anderen Personen zu erkennen. Ein Bild eines Gesichtes wird hier mit Gesichtsbildern in einer Datenbank abgeglichen, um festzustellen, ob Übereinstimmungen gefunden wurden. So soll eruiert werden, wer eine bestimmte Person sein könnte. Staaten setzen Gesichtserkennungstechnologie zur Identifizierung vor allem mit dem Argument ein, die nationale Sicherheit zu schützen. Verdächtige Personen sollen identifiziert und überwacht werden.

Amnesty International schätzt den Einsatz von Gesichtserkennung zur Authentifizierung zum heutigen Zeitpunkt aus menschenrechtlicher Sicht als weniger problematisch ein als den Einsatz zur Identifizierung. Der Einsatz zur Identifizierung ist aufgrund des dahinterstehenden technischen Prozesses sowie aufgrund der Felder, in denen die Technologie zur Anwendung kommt, aus menschenrechtlicher Sicht gefährlich.

Der Einsatz von Gesichtserkennungstechnologien stellt einen massiven Eingriff in unsere Menschenrechte dar, besonders in das Recht auf Privatsphäre. Der automatisierte Einsatz von Gesichtserkennungstechnologie in Echtzeit stellt eine menschenrechtswidrige Form der Massenüberwachung dar, für die es keine Rechtfertigung geben kann. Alle vorbeikommenden Menschen werden erfasst und analysiert, ohne dass ein individueller und begründeter Verdacht gegen sie vorliegt. Aber auch ein nicht in Echtzeit erfolgender Einsatz von Gesichtserkennungstechnologien ist menschenrechtlich höchst problematisch. Zudem werden die von Staaten angekauften Programme mit Fotos trainiert, deren Herkunft datenschutzrechtlich bedenklich erscheint.

Gesichtserkennungssysteme weisen hohe Fehlerquoten auf, können sich diskriminierend auswirken und bestehende Ungleichheiten verstärken. Untersuchungen haben durchwegs ergeben, dass von Gesichtserkennungssystemen einige Gesichter in Abhängigkeit von bestimmten Schlüsselmerkmalen wie Hautfarbe, ethnischer Zugehörigkeit oder Geschlecht genauer erkannt werden als andere.

Vorurteile und strukturelle Ungleichheiten werden durch viele der Algorithmen verstärkt, da die Programme und Systeme jedenfalls in einem ersten Schritt von Menschen programmiert und trainiert werden müssen. Keine dieser programmierenden Personen ist in einem gesellschaftlichen Vakuum aufgewachsen. Unweigerlich trägt jeder Mensch bewusst und unbewusst von Vorurteilen, Stereotypen und Voreingenommenheit in sich, die auf diesem Weg in solche Programme und Systeme einfließen und deren Ergebnisse bzw. Erkenntnisse beeinflussen können. So werden oftmals Stereotypen und Voreingenommenheit in diese Programme einprogrammiert. Für Betroffene gibt es zudem häufig keinen ausreichenden Rechtsschutz, insbesondere deshalb, da diese meist von dem Einsatz der Software nichts wissen.

Der Einsatz von Gesichtserkennungstechnologie kann eine abschreckende Wirkung (sogenannter „chilling effect“) auf die Ausübung des Rechts auf Versammlungs- und Vereinigungsfreiheit sowie Meinungsäußerungsfreiheit haben. Wenn wir alle damit rechnen müssen, überwacht zu werden, beeinflusst das unser Handeln. Wenn Menschen sich überwacht fühlen, kann sie das davon abhalten, sich an Protesten und Versammlungen zu beteiligen.

Eine Gefahr besteht allerdings nicht nur in der Nutzung, sondern auch der Verbreitung von Gesichtserkennungstechnologien. So verkaufen viele Europäische Unternehmen Gesichtserkennungs- und andere Überwachungstechnologie nach China, wo diese gegen marginalisierte Bevölkerungsgruppen zum Einsatz kommt – ohne staatliche Exportkontrolle. Damit riskieren sie, dass diese dort zu schweren Menschenrechtsverletzungen beitragen.

Daher fordert Amnesty International auch ein grundsätzliches Verbot des Einsatzes, der Entwicklung, der Produktion, des Verkaufs und des Exports von Gesichtserkennungstechnologie zu Identifizierungszwecken sowohl durch staatliche Institutionen als auch durch private Akteure.

Es besteht grundsätzlich die Gefahr, auch in Österreich, dass Staaten den Einsatz von Gesichtserkennungstechnologie immer weiter ausbauen. Der Einsatz von Gesichtserkennungstechnologien zur Strafverfolgung ist bereits jetzt weit verbreitet und nimmt weltweit stetig zu.

In Österreich kommt die Gesichtserkennungstechnologie zur Strafverfolgung zum Einsatz. Sie wird laut BMI vom Bundeskriminalamt verwendet, um unbekannte Täter*innen zu identifizieren – unabhängig der Strafhöhe eines Deliktes (das häufigste Delikt ist Diebstahl). Mithilfe der Software sollen Bilder eines Gesichtes, wie zum Beispiel Fotos aus Überwachungskameras, mit den Fotos einer Referenzdatenbank der Sicherheitsbehörden („Zentrale Erkennungsdienstliche Evidenz“) abgeglichen werden.

Im August 2020 wurde der Einsatz von Gesichtserkennungstechnologie zur Strafverfolgung in Österreich nach einer einjährigen Testphase vom Probebetrieb in den Regelbetrieb übernommen. Über diesen nahezu schleichenden Übergang in den Regelbetrieb ist Amnesty International überaus besorgt. Erst nach einer Vielzahl parlamentarischer Anfragen wurden Informationen vom BMI über den Einsatz der Gesichtserkennungssoftware in Österreich bekannt. Aus menschenrechtlicher Sicht besorgniserregend ist insbesondere die Tatsache, dass es keine klare gesetzliche Grundlage für einen Einsatz von Gesichtserkennung in Österreich gibt – und damit verbundene Eingriffe in unsere Menschenrechte somit unrechtmäßig erfolgen.

In Österreich hat das BMI die Software FaceVACS-DBScan von der Atos IT Solutions and Services GmbH sowie der Cognitec Systems GmbH angekauft. Dabei handelt es sich um private Unternehmen; dadurch unterliegen die genaue Programmstruktur sowie der Algorithmus der Software selbst dem Betriebsgeheimnis der privaten Unternehmen und sind daher auch dem BMI nicht bekannt. Dieser Umstand ist deshalb kritisch, da viele Systeme zur Gesichtserkennung eine hohe Fehlerquoten aufweisen und von Voreingenommenheit und Stereotypen beeinflusst sein können. Dadurch können ebendiese Voreingenommenheit und Stereotype verstärkt werden und es besteht somit die mögliche Gefahr einer Verletzung des Rechts auf Gleichheit und Nichtdiskriminierung. Inwiefern das vom Innenministerium angekaufte Produkt dahingehend menschenrechtlich problematisch sein könnte, lässt sich nicht überprüfen. Das ist ein ernsthaftes Problem, denn Staaten sind dazu verpflichtet, Menschen vor Diskriminierung zu schützen.

Zudem besteht hinsichtlich jeglicher Form von Überwachung ein erhöhtes öffentliches Interesse an einer Offenlegung der Funktionsweisen der Algorithmen. Die Tatsache, dass nicht einmal das Innenministerium (BMI) über diese Informationen verfügt, untergräbt das Recht auf Information und führt dazu, dass die zugrunde liegende Technologie keiner Rechenschaftspflicht unterzogen werden kann. In Österreich wird die Gesichtserkennungstechnologie von staatlicher Seite in der Strafverfolgung zur Identifizierung von Personen eingesetzt. Derzeit sind in Österreich potenziell ca. 600.000 Personen vom Einsatz betroffen, nämlich diejenigen Personen, die in der „Zentralen erkennungsdienstlichen Evidenz“ gespeichert sind. Laut Innenministerium werden mithilfe der Software Gesichtsbilder von Personen mit jenen in der erkennungsdienstlichen Evidenz abgeglichen. Als Bild kann hier beispielsweise ein Standbild eines Videos (zum Beispiel aus einer Überwachungskamera auf einem Bahnhof) oder ein Foto verwendet werden. Mithilfe des Abgleichs soll eine Person aus der Datenbank identifiziert werden.

Der Einsatz der Technologie in der Strafverfolgung wird in Österreich laut BMI auf § 75 SPG („Zentrale erkennungsdienstliche Evidenz“) gestützt. Bei der Einführung dieser gesetzlichen Bestimmung hatte der Gesetzgeber jedoch keine derartige Software und vor allem nicht deren Risiken vor Augen. Daher ist diese Bestimmung ungeeignet, eine derartige Technologie – vor allem in Hinblick auf ihre menschenrechtlichen Risken – ausreichend zu regeln. Auch ein späterer gesetzlicher Versuch der Anpassung des § 75 SPG im Jahr 2016 änderte daran nichts: das Gesetz enthält auch weiterhin keine explizite und ausreichende Regelung zum Einsatz von Gesichtserkennungstechnologie. Es besteht die Gefahr, dass es auch in Österreich zu einer schrittweisen Ausweitung des Einsatzes der Gesichtserkennungstechnologie kommt, wie beispielsweise eine Ausweitung auf den sogenannten Echtzeit-Abgleich, die Erweiterung der eingesetzten Datenbanken oder die Ausweitung des Einsatzes auf weitere Datenbanken, wie beispielsweise auf einen Abgleich mit dem Pass- oder Führerscheinregister. Es ist wichtig, zukünftige Einsatzmöglichkeiten zur Massenüberwachung beispielsweise durch Videoüberwachung auf öffentlichen Plätzen frühzeitig hintanzuhalten.

Am Berliner Bahnhof Südkreuz in Deutschland wurde ein Echtzeit-Einsatz von Gesichtserkennungstechnologie durch Strafverfolgungsbehörden getestet. Dieses und andere Vorhaben zur Überwachung deutscher Flughäfen und Bahnhöfe und im Rahmen einer Reform des Bundespolizeigesetzes wurden – nach viel Kritik – bis auf weiteres eingestellt.

In der Volksrepublik China wird Gesichtserkennungstechnologie zur Überwachung von Angehörigen der muslimischen Minderheit der Uigur*innen eingesetzt. Ihr allgegenwärtiger Einsatz wurde vor allem in der Region Xinjiang umfassend dokumentiert.

Mehr als 117 Millionen Erwachsene in den Vereinigte Staaten befinden sich in einer Gesichtserkennungsdatenbank von Strafverfolgungsbehörden. In Australien wird versucht, eine nationale Gesichtsdatenbank für den staatlichen Gebrauch aufzubauen, die Pläne umfassen auch die Nutzung durch Strafverfolgungsbehörden. In mindestens zehn EU-Mitgliedstaaten wird Gesichtserkennungstechnologie von der Polizei eingesetzt.

Im Mai 2019 hat die Stadt San Francisco wegen massiver Missbrauchsbedenken die Verwendung der Technologie durch die Polizei und andere Behörden verboten. Als Folge der Black Lives Matter-Proteste kam es in weiteren Städten in den Vereinigten Staaten zu einem Verbot des Einsatzes von Gesichtserkennungssoftware.

Insbesondere aufgrund hoher Fehlerquoten haben kürzlich Unternehmen wie Amazon, Microsoft und IBM, die Gesichtserkennungssoftware entwickeln, den Einsatz ihrer Produkte zur Strafverfolgung eingeschränkt.

Im April 2021 hat die EU-Kommission einen Verordnungsvorschlag präsentiert, wonach bestimmte Verwendungen von künstlicher Intelligenz verboten werden sollen. Darunter fällt auch die Verwendung von biometrischer Gesichtserkennung zur Strafverfolgung im öffentlichen Raum. Allerdings entspricht aus Sicht von Amnesty International der Vorschlag der EU-Kommission bei weitem nicht den Anforderungen, die zur Minderung des enormen Missbrauchspotenzials von Gesichtserkennungstechnologien erforderlich sind. Der Vorschlag verbietet die Verwendung von Gesichtserkennungstechnologie zur Echtzeit-Erkennung durch Strafverfolgungsbehörden im öffentlichen Raum, jedoch sollen unter bestimmten Voraussetzungen Ausnahmen für dieses Verbot gelten. Zudem ist der Einsatz von Gesichtserkennungssoftware durch Strafverfolgungsbehörden – aus Bildmaterial von öffentlichen Videokameras – grundsätzlich auch weiterhin möglich, sofern der Abgleich nicht in Echtzeit stattfindet.